RAG (Récupération Augmentée de Génération) a révolutionné l'IA conversationnelle. Cette technique permet aux agents conversationnel d'accéder et d'exploiter des bases de connaissances externes, c'est-à-dire votre domaine ou des données en temps réel, en les adaptant à vos besoins. Cela a conduit à une explosion des chatbots RAG !

Dans cet article, nous comparerons deux options populaires pour gérer les LLM (modèles de langage de grande taille) utilisés dans les chatbots RAG : watsonx.governance d'IBM et Dataiku, qui peuvent tous deux fonctionner sur site ou dans le cloud. Nous explorerons leurs forces et verrons comment ils peuvent être appliqués dans des scénarios réels.

Tout d'abord, pourquoi utiliser une solution de gouvernance LLM pour les chatbots RAG ?

Imaginez que vous avez construit un agent conversationnel de service client RAG alimenté par un LLM. Vous voulez qu'il réponde aux questions avec précision, évite le langage offensant et protège la vie privée des clients. Une solution de gouvernance GenAI peut vous aider sur tous ces fronts.

Voici quelques fonctionnalités clés à considérer :

- Mesures de performance : Ces mesures évaluent la performance de votre LLM. Par exemple, un outil pourrait utiliser des scores BLEU pour évaluer la qualité des réponses générées par votre agent conversationnel RAG, comme fournir des résumés clairs et concis de sujets complexes.

- Sécurité et conformité : Ces fonctionnalités vous aident à respecter les réglementations. L'outil pourrait détecter les informations personnellement identifiables (PII) telles que les numéros de sécurité sociale dans les conversations de votre agent conversationnel pour s'assurer qu'elles sont gérées en toute sécurité.

- Explicabilité et transparence : Cela vous permet de comprendre comment votre LLM prend des décisions. Ceci est crucial dans des domaines comme la finance, où vous pourriez avoir besoin d'expliquer pourquoi votre agent conversationnel recommande un produit particulier.

Paysage de la gouvernance de l'IA — IBM et Dataiku

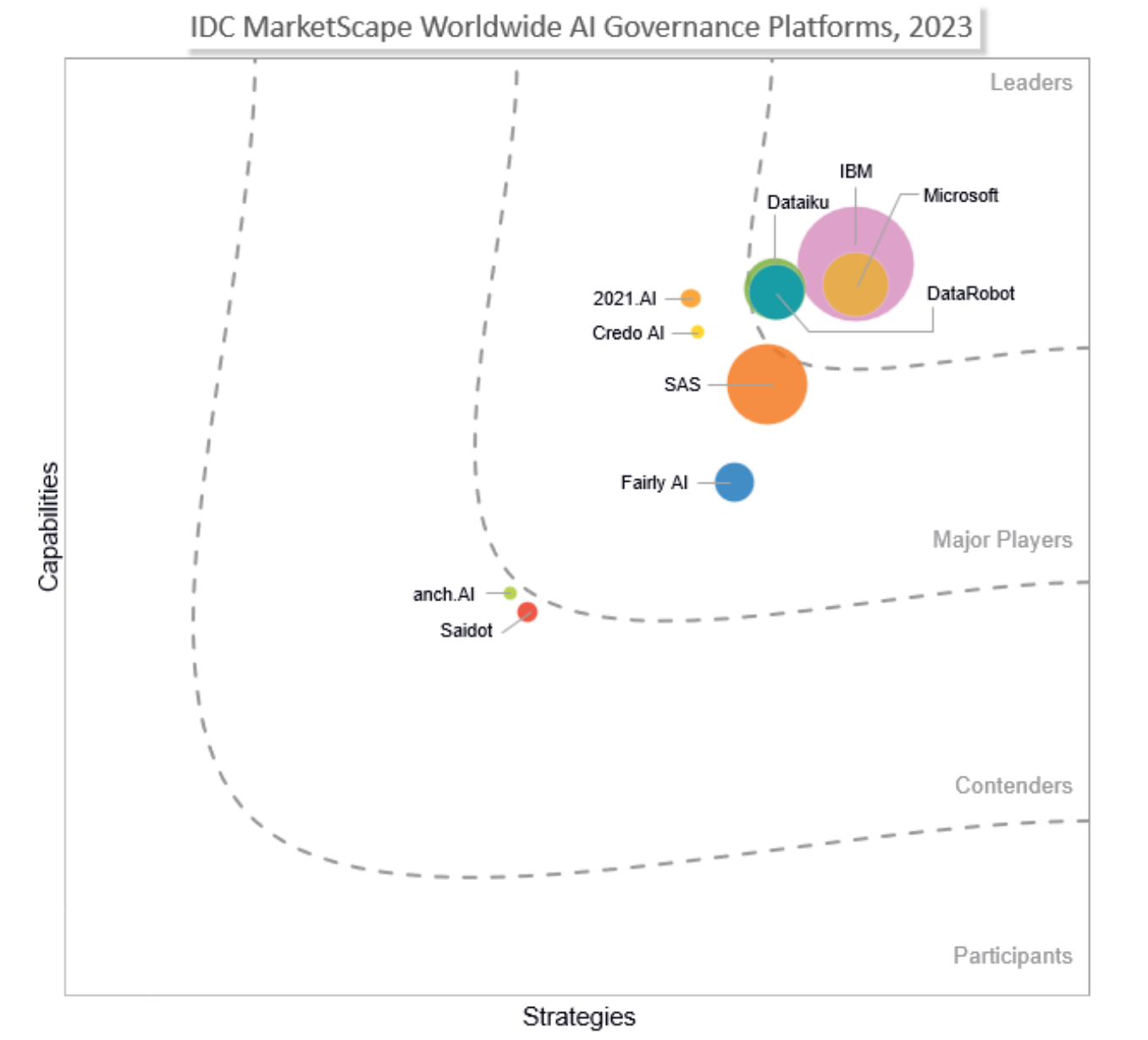

L'IDC MarketScape Worldwide AI Governance Platforms for 2023 met en évidence les leaders de la gouvernance de l'IA. Selon ce rapport, IBM est positionné comme leader de premier rang, tandis que Dataiku est positionné comme leader de second rang, comme le montre la figure ci-dessous.

Source: IDC 2023

watsonx.governance vs. Dataiku : Un Regard Approfondi

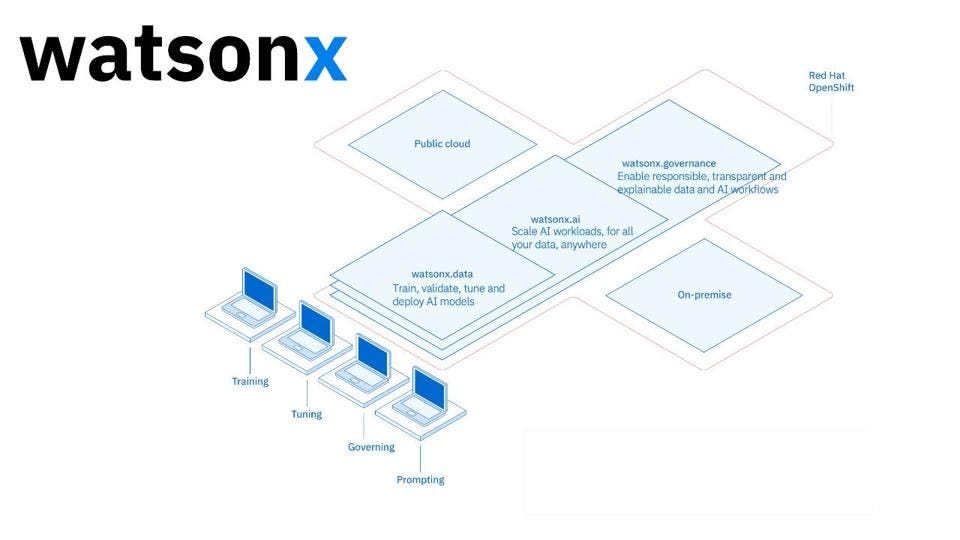

IBM watsonx (sur site ou SaaS)

watsonx.governance aide les clients à gouverner l'IA dans 3 domaines clés :

- Gouvernance du cycle de vie — Accélérer la construction de modèles à grande échelle. Automatiser et consolider plusieurs outils, applications et plateformes tout en documentant l'origine des ensembles de données, des modèles, des métadonnées associées et des pipelines.

- Gestion des risques et protection de la réputation — Favoriser des modèles d'IA responsables, explicables et de haute qualité, et documenter automatiquement la lignée des modèles et les métadonnées. Surveiller l'équité, les biais et les dérives, définir des tolérances d'alerte pour une atténuation des risques en temps opportun.

- Conformité aux réglementations, normes et politiques — Soutenir la conformité en utilisant des protections et des validations pour créer et déployer des modèles équitables, transparents et conformes. Utiliser des fiches techniques pour capturer et documenter automatiquement les métadonnées et les faits des modèles à l'appui des audits.

Voici quelques points forts de watsonx.governance pour les LLM :

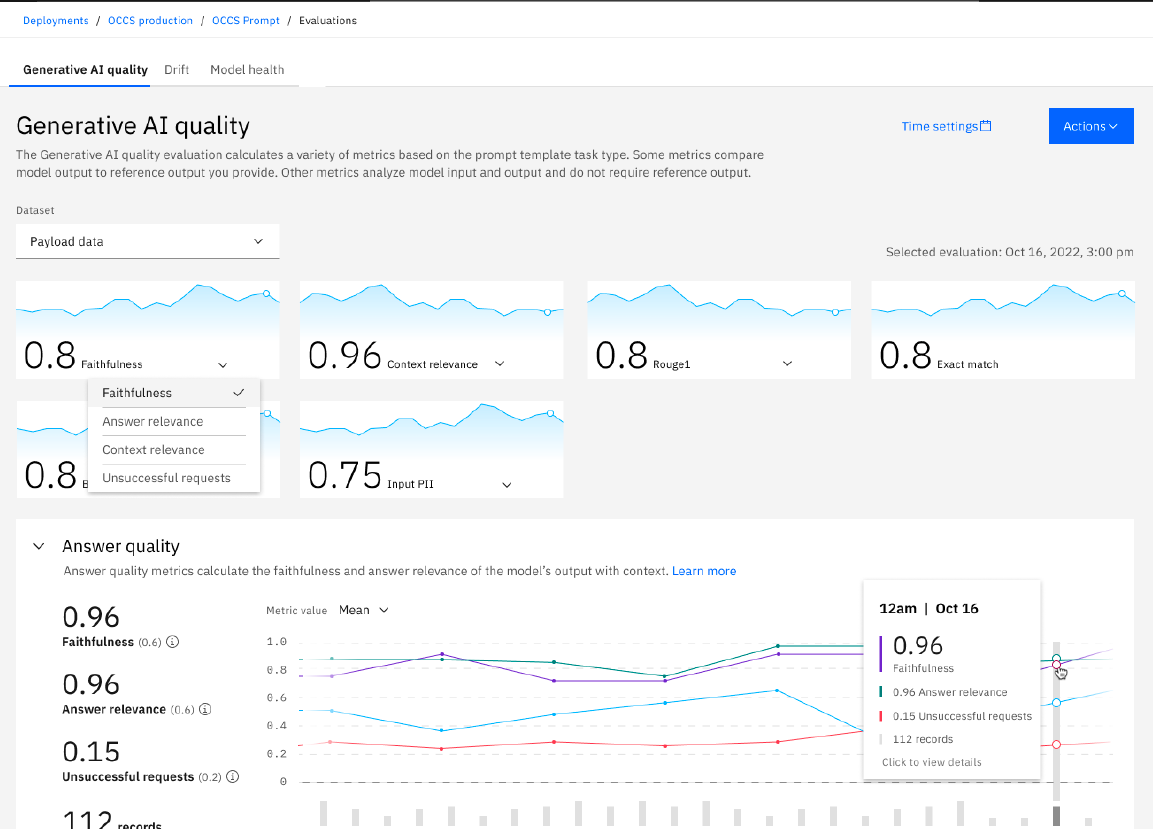

- Évaluer et surveiller les hallucinations et la qualité des réponses pour le RAG : Les utilisateurs peuvent surveiller et évaluer l'utilisation du RAG par GenAI en utilisant des métriques prêtes à l'emploi telles que la fidélité, la pertinence des réponses, les demandes infructueuses, l'inclusion de mots-clés, l'analyse de contenu, la robustesse des questions, etc., pour atténuer les hallucinations. La plateforme visualise également les tendances au fil du temps.

You can assess metrics for individual responses with visualization to easily understand / assess response thru watsonx.governance

You can assess metrics for individual responses with visualization to easily understand / assess response thru watsonx.governance

Vous pouvez évaluer les métriques des réponses individuelles avec une visualisation pour comprendre et évaluer facilement les réponses via watsonx.governance

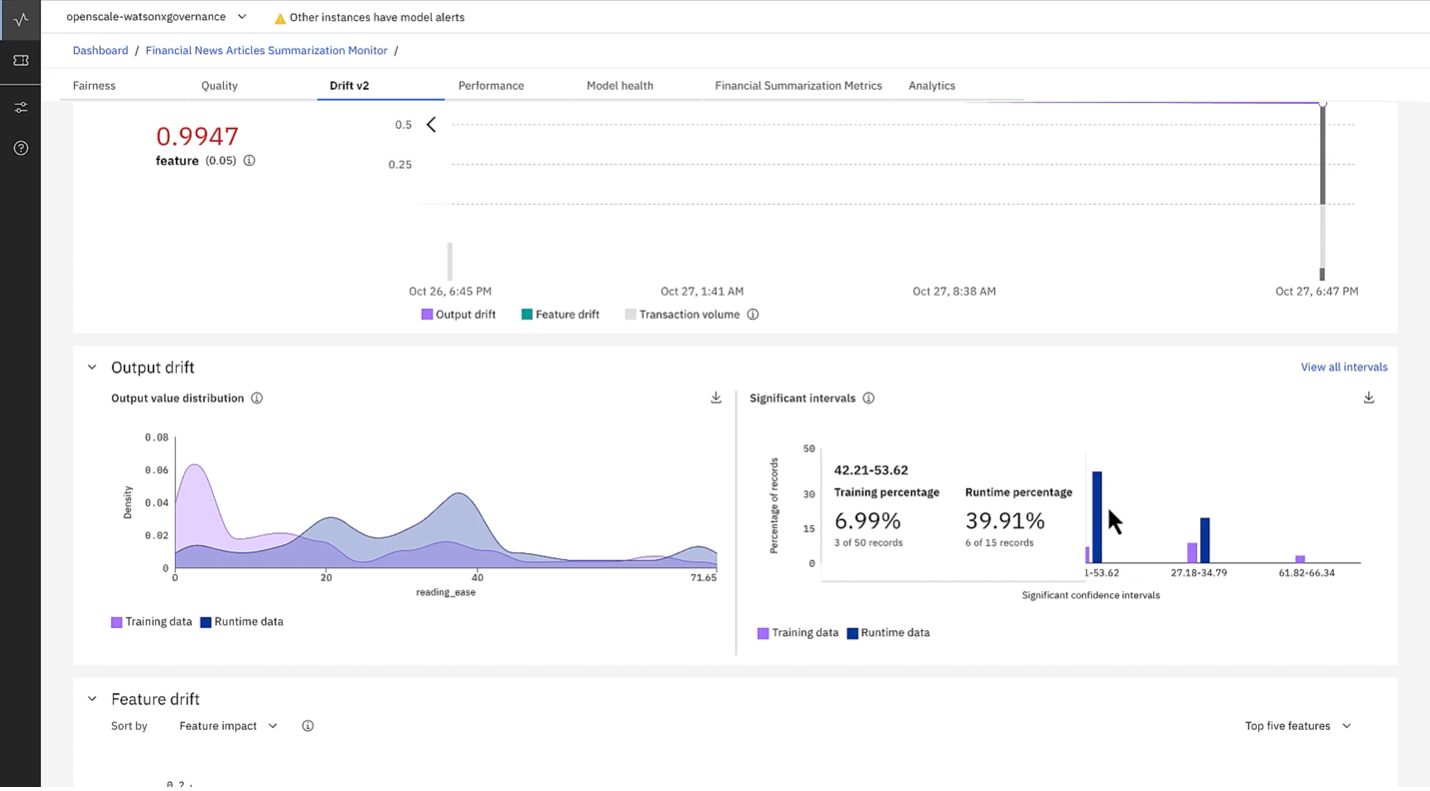

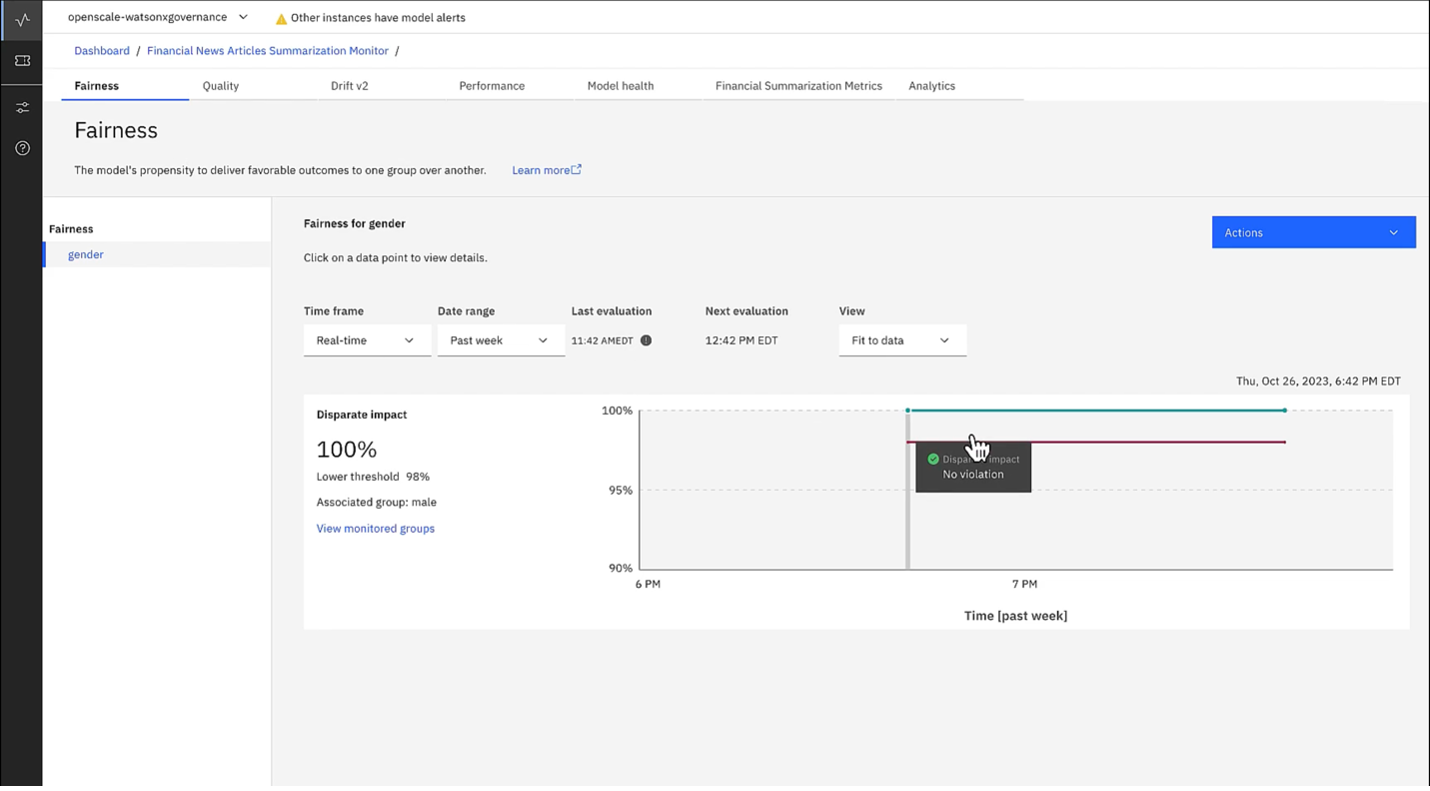

- Surveiller la dérive en temps réel : De nombreux utilisateurs sont intéressés par la surveillance de la dérive des modèles, qui se réfère à la diminution progressive de la qualité des résultats du modèle au fil du temps. Pour atténuer l'impact de la dérive, watsonx.governance surveille l'écart entre les résultats des LLM et des modèles prédictifs par rapport aux résultats idéaux, et alerte les utilisateurs si les métriques de dérive passent en dessous des seuils spécifiés. Les utilisateurs peuvent alors prendre des mesures appropriées, telles que le réentrainement des modèles ou la modification des invites pour atténuer l'impact de la dérive, comme le montre la figure suivante.

- Suivi de l'équité : Cette solution fournit des rapports détaillés sur l'importance des caractéristiques et les scores d'impact. Cela vous aide à comprendre quels facteurs influencent le plus les réponses de votre LLM, vous permettant d'affiner son comportement pour des tâches spécifiques.

- Approche indépendante de la plateforme : Cela signifie que vous pouvez intégrer ses outils de gouvernance directement dans l'environnement de chaque modèle d'IA, quel que soit le fournisseur. Cette flexibilité garantit que des pratiques de gouvernance cohérentes sont appliquées à tous vos modèles d'IA, en maintenant le contrôle et la sécurité, même dans un environnement multi-fournisseur.

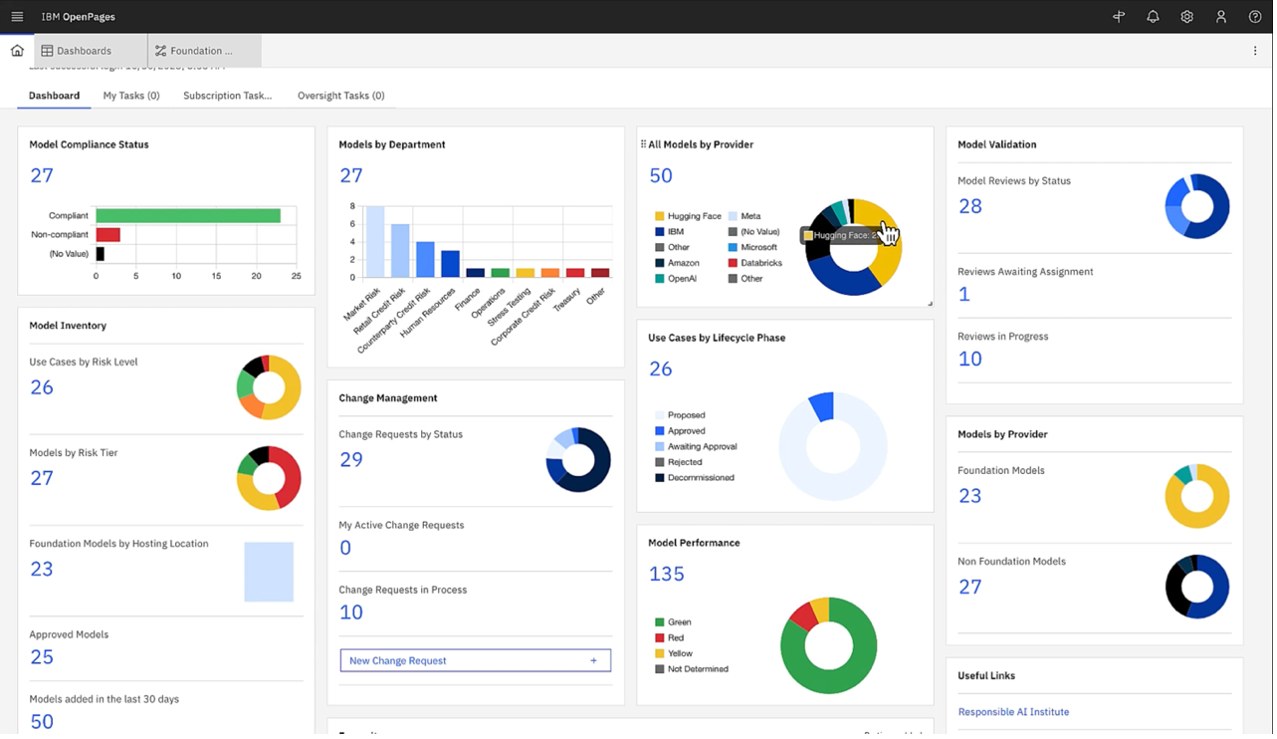

- Informations personnalisées pour tous les niveaux : Vous pouvez créer des tableaux de bord centralisés au sein de la plateforme ou exporter ses rapports. Adaptés à différents publics, des data scientists aux dirigeants de niveau C, ces tableaux de bord garantissent que chacun dispose des informations nécessaires pour gouverner et permettre des LLM responsables, explicables et de haute qualité.

Single and Custom dashboard overview of all kinds of AI/ML model metrics, including risk levels.

Single and Custom dashboard overview of all kinds of AI/ML model metrics, including risk levels.

Vue d'ensemble du tableau de bord unique et personnalisé de tous les types de métriques des modèles AI/ML, y compris les niveaux de risque.

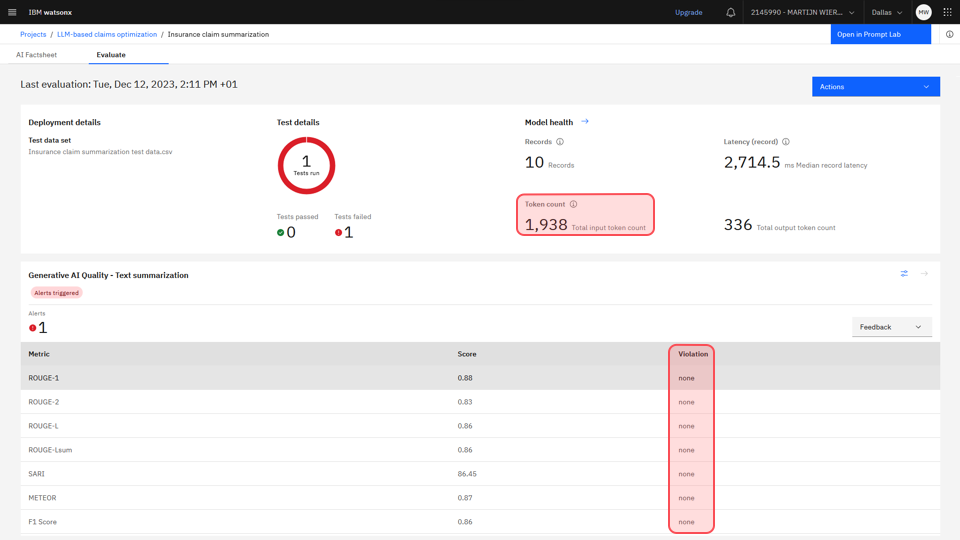

Tableau de bord de surveillance pour le déploiement de modèles de prompt : La section "Santé du modèle" affiche les métriques de performance, y compris le nombre de jetons. Les métriques sous l'en-tête "Qualité de l'IA générative" mesurent la précision du modèle. Les colonnes de violation ne montrent aucun avertissement, tous étant dans les plages acceptables.

- Évaluer l'applicabilité des réglementations : Il offre un questionnaire prêt à l'emploi pour évaluer l'applicabilité de l'IA de l'UE pour les cas d'utilisation de l'IA, afin de les adapter à vos besoins.

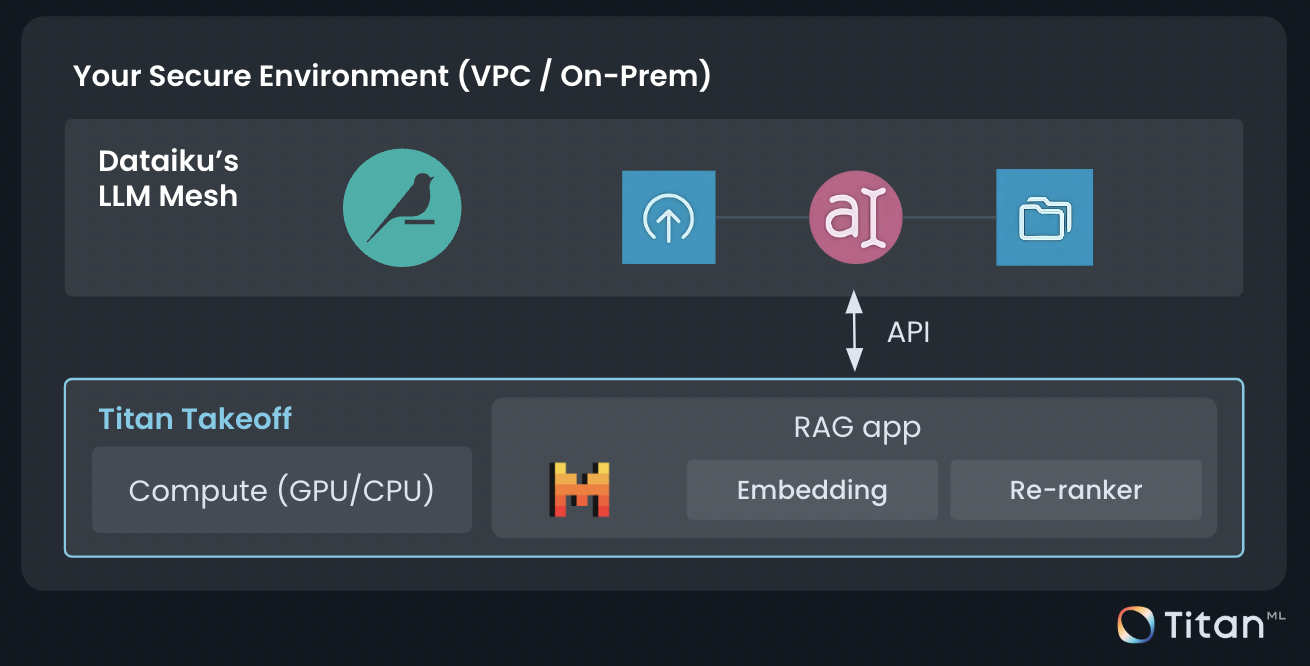

Dataiku, quant à lui, permet à l'informatique de prendre le contrôle et d'aider les équipes à construire des applications GenAI sûres et sécurisées avec l'épine dorsale de LLM Mesh. Voici ce qu'il offre :

- Contrôlez directement vos prompts et LLMs : LLM Mesh est à l'opposé de ce que signifie watsonx.governance. Dataiku souhaite que vous exécutiez tout via la plateforme Dataiku. C'est une couche de routage et d'orchestration entre les applications et les LLMs ; elle fait partie du paysage des "FMOps" (Foundation Model Operations).

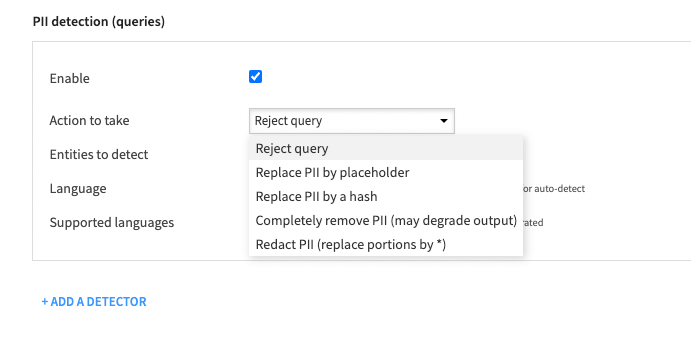

- Détecter les PII et prendre des mesures : En tirant parti de l'analyseur Presidio, la détection des PII peut être ajoutée au niveau de la connexion pour filtrer chaque requête et définir une action à entreprendre. Cela peut aller de la prévention pure et simple de la requête à la simple substitution des données sensibles.

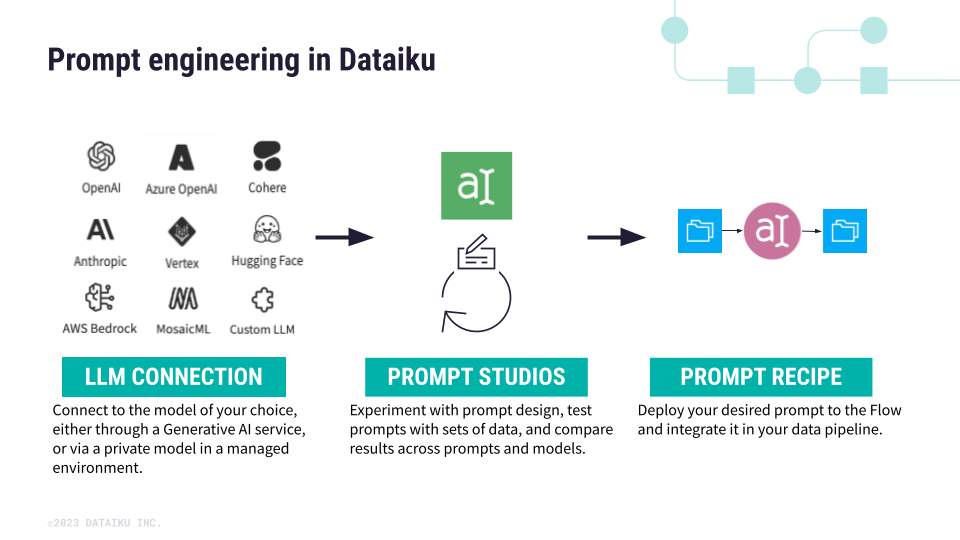

- Ingénierie de prompt : Dataiku fournit des outils pour concevoir et gérer les prompts que vous donnez à votre LLM, avec un coût estimé à 1 000 enregistrements. Cela peut être utile pour des tâches comme la création de différents styles d'écriture ou l'adaptation du ton du LLM pour divers publics grâce à des tests A/B dans le cadre du budget.

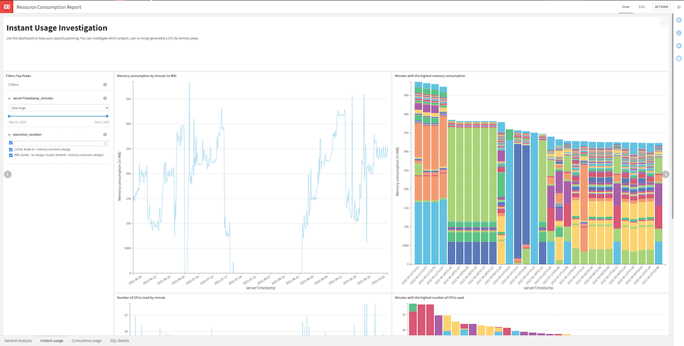

- Suivi des coûts : Dataiku peut extraire automatiquement les informations sur les coûts des LLM et l'utilisation des ressources de calcul (CRU) à partir des journaux d'audit et présenter des insights dans un tableau de bord prêt à l'emploi.

Choisir le bon outil pour votre LLM

La meilleure solution de gouvernance GenAI dépend de vos besoins spécifiques. Voici un aperçu pour vous aider à décider :

Choisissez watsonx.governance si vous :

- Avez besoin d'une solution complète pour gérer plusieurs LLM et outils d'IA.

- Voulez un outil flexible qui fonctionne avec diverses plateformes LLM. Cela permet une intégration avec l'infrastructure existante et évite le verrouillage par un fournisseur.

- Avez besoin de fonctionnalités de transparence pour comprendre le processus de décision de votre LLM, surtout dans le cas de données sensibles ou de scénarios délicats.

- Exigez des fonctionnalités avancées de sécurité et de conformité pour garantir la confidentialité des données.

Choose Dataiku if you:

- Préférez une plateforme centralisée liée à la plateforme Dataiku elle-même pour gérer tous vos workflows LLM. Notez qu'il existe un risque de verrouillage par la plateforme si vous souhaitez utiliser d'autres plateformes ou services LLM à l'avenir.

- Avez besoin de suivre de près les performances et les coûts d'exécution de votre LLM.

- Voulez un endroit central pour surveiller le déploiement et les performances de votre LLM.

En résumé

En fin de compte, le choix entre watsonx.governance d'IBM et Dataiku dépend de vos besoins. Si vous souhaitez une gouvernance simple et que vous n'avez pas de problème à contrôler les modèles via une seule plateforme, alors la centralisation du routage et de l'orchestration via Dataiku pourrait être un bon choix. Cependant, si la flexibilité pour éviter le verrouillage par la plateforme et la construction d'un LLM conforme et digne de confiance est primordiale, alors une solution de gouvernance indépendante des plateformes avec un accent sur la conformité réglementaire comme watsonx.governance pourrait être une meilleure option.

#watsonx.governance